Životní cyklus dat a proč nic nevynechat | Mňamka #106

Často na prvních schůzkách slýcháme větu: “Tady mám vyexportovaný excel s účetnictvím a potřebuju ho napojit na GoodData…”.

Tak jako asi by to nějak teoreticky šlo, ale dnes se vám pokusím ukázat, proč to takto vlastně dělat nechcete...

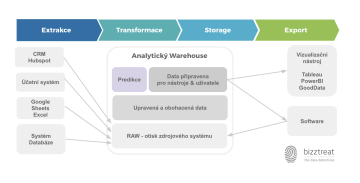

A začneme u toho, co se s našimi daty děje celou tou dlouhou cestou od vzniku někde ve zdrojovém systému (účetní systém, FB, Hubspot,….) až po to, kdy koukáte na graf na vaší obrazovce počítače.

Vysypeme data z krabic

Extrakce ze zdrojových systémů nebo také jednoduše - získávání dat. Tak jak si to vlastně představit. Pravděpodobně máte někde uloženy nebo sbíráte informace o zákaznících (Hubspot), o účetnictví (Pohoda) nebo třeba o logistice (SAP) atd…Těmto všem “krabicím” říkáme zdrojové systémy. V nich mají vaše data nějakou strukturu, čistotu a kvalitu. Jsem přesvědčená o tom, že velké procento z nich nebude v pořádku. Co tím myslím? Do vašich krabic vkládají data pravděpodobně lidé, takže budou plné překlepů, mezer, špatných datových typů nebo budou rovnou chybět úplně.

A tady máme první “proč nic nevynechat”. Představte si, že si stáhnete třeba CSV s daty vašich zákazníků a nahrajete do GoodData. Po chvíli budete překvapeni, že vidíte špatná čísla, často i úplné nesmysly a nejde vám vytvořit žádná kloudná vizualizace. Ano, je to proto, že se v datech vyskytují chyby, špatné datové typy nebo chybí údaje - prostě s tímhle si vizualizační nástroj neporadí. Pokud nechcete vymazávat mezery ve všech řádcích ručně, potřebujete data vyčistit. A pokud se chcete dozvědět i něco navíc, musíte obohacovat.

Data vyčistíme, propojíme a obohatíme

Abychom s daty mohli pracovat, potřebujeme je dostat ze zdrojového systému, protože v nich SQL v drtivé většině nepoužijeme. Mají prostě jiný účel než je hrát si s daty. Cílem je je dostat někam, kde s nimi můžeme pracovat, kde je můžeme očistit, aby byla stravitelná k dalšímu použití. Třeba je i rovnou lépe strukturujeme. A taky je propojíme a obohatíme. A tady máme druhé“proč nic nevynechat”. Představte si, že chcete vědět nejen informace o zákazníkovi, ale i kolik průměrně utratil za poslední měsíc nebo kdy udělal poslední objednávku. Ano, všechny informace někde máte, ovšem pokaždé v jiné “krabici”. Propojením získáte úplně nové informace, úplně jinou odpověď na vaši business otázku.

Jednoho dne tedy přijde chvíle, kdy budeme potřebovat data ze zdrojových systémů získat a vylít na jednu hromadu tak, jak jsou (tomu říkáme Raw Stage). To jakým způsobem pak jednotlivé fáze probíhají je otázka, existují dva základní přístupy ETL (extract - transform - load) a ELT (extract - load - transform). Jak to třeba řešíme my pomocí cloudových služeb se můžete podívat na tomto videu.

Nedávno jsme v této souvisloti narazili na technologii dbt - data built tool a se k tomu snad jen říct, že tuhle pecku si žádný analytik nesmí nechat ujíst. Je to nástroj (opensource), který se v ETL stará o to “T”. Základem je projekt, který se konfiguruje sadou YAML souborů a SQL souborů s makry. Řekla bych, že jde o nový způsob tranformace dat.

Nad vyčištěnými daty se pak dělají všechny ty vizualizace, predikce, ML atd.

Data máme na jedné hromadě

Je vlastně potřeba vzít nějakou jinou, pro naše účely vhodnou, krabici a data z našich původních krabic mít tam. A tady to zase může být různé - někdy máme všechna data na hromadě, často ale máme na hromadě jen ta data, která potřebujeme k našich analýzám. Někdy tam máme i historii, někdy ne… Prostě co use case, to případ. My pro tyhle potřeby využíváme cloudových služeb (Google Cloud Platform / Amazon AWS / MS Azure) - jsou bezpečné a hlavně platíte jen za data co máte a využíváte. Pro ukládání dat pak využíváme jejich analytické databáze - Google BigQuery, Amazon Redshift, Azure Synapse a nebo taky oblíbený Snowflake. Jaké jsou mezi nimi rozdíly krásně shrnul Radovan na našem blogu.

Konečně to vidíme

Hurá! Špička ledovce! To je to, co zajímá business, ne ty týdny práce pod tím :-) Takže, data získáváme ze zdrojových systémů, čistíme, obohacujeme, spojujeme a ukládáme do různých vrstev nebo struktur k následné konzumaci. Klasická konzumace v business intelligence světě je pomocí vizualizačních nástrojů - my máme rádi v podstatě čtyři (v odkazech najdete jejich srovnání, jejich užití) - Tableau, PowerBI, GoodData a CleverMaps. Pokud máte dobré a pevné základy, vizualizační nástroje fungují rychle a vy konečně vidíte ta správná čísla. A pokud vás zajímá, jak by měla taková vizualizace vypadat a jaká by se měla dodržovat pravidla, mrkněte třeba na naše články: 8 chyb při zadávání dashboardu, Data Storytelling nebo Barevný svět Business Intelligence.

Ještě zmíním jeden případ. Představte si, že výstup není vizualizace, ale třeba data pro call centrum, která se jim zobrazují v jejich systému. Získají tak třeba kompletní obrázek o zákazníkovi, o jeho životním cyklu, objednávkách atd. A teď si představte situaci, že se během hovoru operátorka dozví, že zákazník má novou informaci. Operátorka tedy do systému ručně napíše informaci XY - tím se software call centra stává datovým zdrojem a tato informace putuje do RAW stage, kde se s ní bude může dále pracovat.

Takže, co z toho plyne

Ano, jsou případy, kdy se můžete na svá data podívat přímo ve vizualizačním nástroji. Když pominu tu manuální práci s tím, tak se hlavně vystavujete riziku nekvalitních dat a přicházíte o nové pohledy a informace.

Zapomněli jsme na něco? Chcete se na něco zeptat? Napište nám.

AI Audit: Když chcete vědět, kde ve firmě AI dává smysl (a kde ne)| Mňamka #552

Znáte to – CEO se vrátí z konference a ptá se „a my s tou AI něco děláme?“, IT má pět různých nápadů, co by se dalo zkusit, marketing chce chatbota, a ve skutečnosti nikdo přesně neví, co z toho má smysl a kde začít. AI audit je pro firmy, které nechtějí jen naskakovat do vlaku, ale chtějí vědět, kam ten vlak vlastně jede. Typicky to jsou střední a velké společnosti, které už mají digitalizované procesy a nějaká data – a teď zjišťují, že „AI strategie“ nemůže být „zkusíme, uvidíme“.

Metadata management: Proč je katalog dat nutností, ne luxusem | Mňamka #551

“Metadata jsou data o datech.“ - tohle, když od nás slyšeli profesoři na VŠE (Vysoké škole ekonomické), rovnou nás poslali ze zkoušky domů s tím, že se za nedlouho opět uvidíme. 😀Ona je to sice pravda, ale nejde ani tak úplně o jednu pevně stanovenou “definici” jako spíš o tu samotnou podstatu. Díky metadatům organizace chápe svá data, své systémy i pracovní postupy, protože metadata popisují, vysvětlují a usnadňují vyhledání, použití a správu jakéhokoliv datového zdroje.

7 nejběžnějších promptů datového analytika a inženýra | Mňamka #550

Datoví analytici a inženýři tráví spoustu času rutinními úkoly – od čištění dat až po ladění kódu. Umělá inteligence dnes dokáže část téhle práce výrazně urychlit. Klíčem je dobře napsaný prompt – zadání, kterým AI přesně řeknete, co má udělat. Podívejme se na 7 promptů, které se v praxi hodí nejčastěji.