MS Fabric: Pojďte si s námi vytvořit první pipeline - 1.část | Mňamka #540

Otevřeli jste poprvé MS Fabric a vůbec se nerorientujete? Už máte zadání a nevíte kam dřív? V tom případě jste tady správně, protože vás provedeme prvními krůčky, jak si dotáhnout do Fabricu první data, zpracovat je a nastavit celý proces v jednoduché pipeline. Ukažte ostatním, jak se to dělá!

V tomto článku si představíme konkrétně kroky jako kopírování dat, dataflow, notebooky a zprovoznění pipeline.

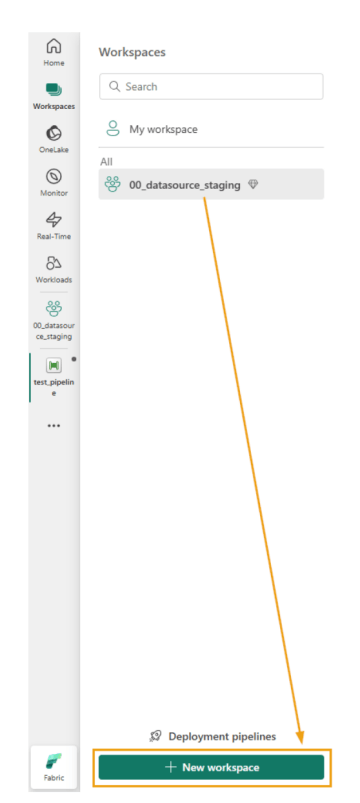

1) WORKSPACE

Pokud máte založený workspace, otevřete si ho. Pokud ne, založte si ho.

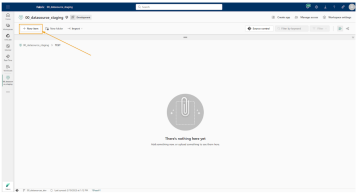

2) DATA PIPELINE

Data pipeline je soubor procesů a nástrojů, které umožňují sběr, zpracování, transformaci a načítání dat z jednoho nebo více zdrojů do cílového úložiště, kde mohou být následně analyzována nebo použita pro další účely.

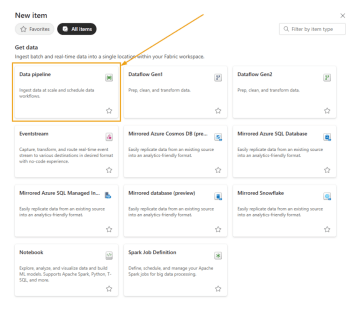

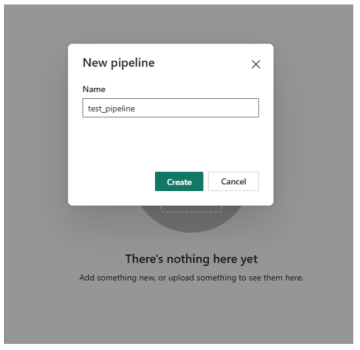

Pro pipeline můžeme vytvořit složku, nebo ji vložit přímo do workspacu pomocí tlačítka New item. Rozbalí se vám široká nabídka objektů, které budete v rámci práce s MS Fabric potřebovat. Vytvoříme objekt Data pipeline. Pojmenujeme ho dle potřeby a můžeme začít.

3) COPY DATA

Prvním krokem v naší pipeline je Copy Data, tedy kopírování dat ze zdroje. Může jít jak o externí zdroj, například SQL databázi, SFTP server, cloudové úložiště, tak o kopírování dat, které jsme si připravili v rámci našeho Lakehousu.

Pomocí tlačítka Copy Data (Add to canvas nebo Use Copy Assistant) vytvoříte Copy Data job, který slouží k přesunu dat mezi zdrojem a cílovým úložištěm.

V jeho nastavení upravíte:

Název – pojmenujte job podle účelu.

Zdroj dat – například SFTP, Blob Storage, SQL databáze, API.

Cílové úložiště – určíte, kam se mají data uložit (OneLake, Data Lake, Blob Storage).

Formát výstupu – CSV, Parquet, JSON, Delta atd.

Mapování sloupců – pokud je třeba přizpůsobit strukturu dat.

Další nastavení – například filtrování dat, plánování běhu, změna datových typů.

V našem případě data uložíme jako soubory (nikoliv tabulky), protože jsou vhodnější pro větší objemy dat. Následně je budeme transformovat pomocí Dataflow, kde provedeme další úpravy a přípravu pro analytické zpracování.

Proč soubory?

Efektivní ukládání – formát Parquet je sloupcově orientovaný, což šetří místo a urychluje dotazy.

Flexibilita – soubory lze snadno zpracovávat dávkově nebo načítat postupně.

Nižší náklady – u cloudových řešení může být levnější ukládání souborů než provoz databáze.

Možnost paralelizace – zpracování souborů lze škálovat v distribuovaných systémech.

Kdy raději tabulky?

Pokud potřebujete okamžitý přístup k datům přes SQL dotazy.

Pokud jsou data často aktualizována a je nutné zajištění konzistence.

Pokud pracujete s menšími, dobře strukturovanými datasety.

Pokud potřebujete získat surová data ze zdroje, která mají složitější strukturu (například xlsx soubor, ve kterém jsou vnořeny další xlsx soubory), a do Microsoft Fabric je potřebujete dostat jako oddělené soubory a roztřídit je zároveň do správných složek, místo Copy Data jobu si vytvoříte Notebook.

V něm pomocí Pythonu / PySparku napíšete kód, který například:

Načte zdrojový soubor (např. z SFTP, ADLS, OneLake)

Rozbalí a rozdělí jednotlivé vnořené soubory

Přetřídí je podle logiky (např. podle názvu, datumu, typu obsahu)

Uloží je do příslušných složek v Lakehousu v požadovaném formátu

Tento přístup umožňuje větší flexibilitu, pokud potřebujete předzpracovat nebo transformovat data před jejich uložením.

4) DATAFLOW

Dataflow v Microsoft Fabric je vizuální nástroj pro přípravu, transformaci a čištění dat bez nutnosti psát kód. Pokud ale potřebujete pokročilé úpravy, můžete použít jazyk Power Query M a pomocí Advanced editoru dataflow upravit/rozšířit.

Dataflow si vytvoříte ve vašem workspace jako samostatný objekt. V nastavení jobu (Settings) si pojmenujete job a vyberete již existující dataflow, které chcete v pipeline použít.

I v tomto případě můžeme k transformaci dat použít notebook místo dataflow. Kdy je tedy vhodné použít notebook a kdy dataflow? Níže si ukážeme hlavní body.

Kritérium | Použití Notebooku (PySpark, SQL, Python) | Použití Dataflow (Power Query M) |

Úroveň kódování | Vyžaduje kódování (Python, PySpark, SQL) | Bez kódu, používá grafické rozhraní |

Složitost transformací | Pokročilé transformace, složité algoritmy | Jednoduché transformace (joiny, agregace, filtrování) |

Objem dat | Vhodné pro velké objemy dat (paralelizace, distribuované výpočty) | Vhodné pro menší až středně velká data |

Flexibilita | Vysoká flexibilita a možnosti přizpůsobení | Méně flexibilní, ale rychlé pro základní úpravy |

Rychlost zpracování | Rychlejší pro velké datové sady díky PySpark | Může být pomalejší při zpracování velkých dat |

Podpora různých formátů | Vysoká podpora pro různé datové formáty (JSON, XML, Parquet, atd.) | Podporuje základní formáty jako CSV, Excel, Parquet |

Použitelnost pro BI nástroje (např. Power BI) | Nepřímé propojení, data je třeba uložit do tabulky | Přímé propojení s Power BI |

Náklady | Vhodné pro větší objemy dat a komplexní výpočty, může být dražší | Levnější pro menší objemy dat a jednoduché úpravy |

Automatizace | Možnost automatického spouštění notebooku na základě plánování | Podporuje plánování a automatické aktualizace bez nutnosti kódování |

Každá situace může však mít specifické požadavky a doporučuji se vždy podívat na oficiální dokumentaci, abyste si ověřili detaily, které se mohou změnit s aktualizacemi platformy.

Budeme pokračovat částí 2 v následujícím článku.